|

Di seguito gli interventi pubblicati in questa sezione, in ordine cronologico.

La dobbiamo chiamare l' astronave dei record. Non si tratta del Millennium Falcon o dell'Enterprise, ma di una sonda da 258 chilogrammi che risponde al nome di Pioneer 10. Insomma, una navicella spaziale molto più contenuta rispetto ai giganti della fantascienza, ma che vanta comunque una serie di primati storici.

Tanto per cominciare, il 2 marzo 1972 decolla da Cape Canaveral, in Florida, e schizza in cielo alla velocità di 52mila chilometri all'ora. Quanto basta per lasciarsi la Luna alle spalle in 11 ore e bypassare Marte dopo 12 settimane di viaggio e 80 milioni di km di corsa. Il 15 luglio, Pioneer 10 segna il primo record spaziale facendo il suo ingresso nella fascia di asteroidi che separa i pianeti interni del Sistema Solare da quelli più esterni. Come sa benissimo anche Han Solo, attraversarla non è esattamente uno spasso: un labirinto esteso 280 milioni di km dove polveri e ammassi di roccia grandi quanto l'Alaska sfrecciano a velocità di 20 chilometri al secondo.

Secondo record: Pioneer 10 supera la fascia di asteroidi e, il 3 dicembre 1973, entra finalmente in contatto con Giove. Nessun dispositivo costruito da un essere umano era mai riuscito a raggiungere il quinto pianeta del Sistema solare. Nell'incrociarlo, la navicella scatta le prime immagini ravvicinate della sua superficie e ne mappa il campo magnetico. Non capita tutti i giorni di passare vicino a un gigante gassoso dal volume mille volte quello della Terra.

Ma la missione di Pioneer 10 non si ferma qui: dopo essersi lasciato anche Giove alle spalle, la navicella punta verso i confini del Sistema. Durante il suo lungo viaggio verso lo Spazio esterno, gli strumenti di bordo raccolgono dati preziosi sui venti solari e i raggi cosmici che provengono dalla nostra galassia. Purtroppo, man mano che la sonda si avventura oltre Plutone, il suo segnale diviene sempre più debole.

La Nasa dichiarò conclusa la missione Pioneer 10 il 31 marzo 1997, ma continuò a tracciare il segnale della navicella per studiare nuovi metodi di comunicazione da implementare sulle nuove sonde extrasolari. Pioneer 10 ha tenuto duro fino al 23 gennaio 2003, quando la stazione di controllo terrestre ha ricevuto il suo ultimo segnale radio.

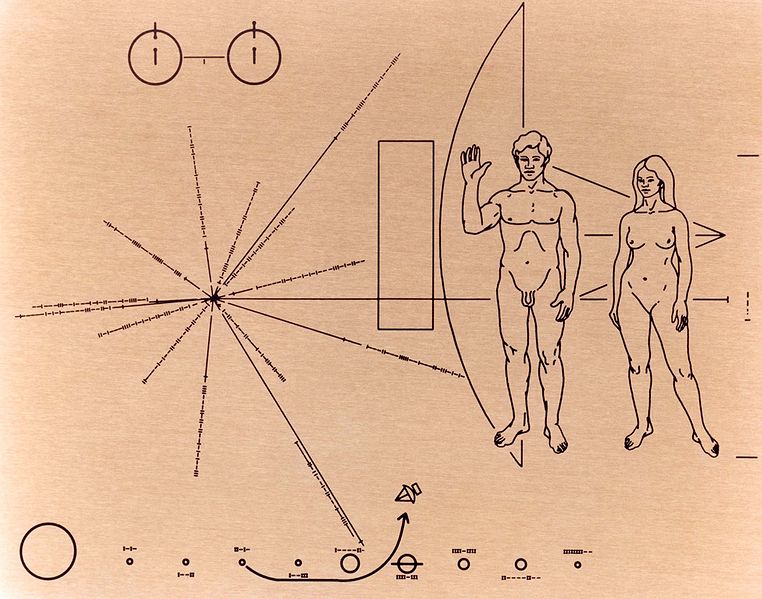

Trent'anni di missione fuori dal sistema solare sono troppi anche per un guscio di metallo, figurarsi per un essere umano. Eppure, anche se i sistemi di alimentazione di Pioneer 10 sono ormai fuori uso, la navicella forse riuscirà a portare a termine un'altra missione. Quella di portare un messaggio degli abitanti della Terra alle forme di vita intelligente che potrebbero trovarsi da qualche parte nella galassia. Il dispositivo infatti reca a bordo una placca di alluminio anodizzata che raffigura un uomo, una donna e la provenienza dell'astronave. Chissà quante possibilità abbiamo di vedercela riportare indietro.

Fonte: wired.it

Anatomia di un attacco di Anonymous. Cita così il report che Imperva, un’azienda californiana di sicurezza digitale, è pronta a diffondere questa settimana nel corso di una conferenza sul tema. Dentro infatti ci sono scritte alcune delle strategie utilizzate dagli hackers di Anoymous - tra le cui fila sono stati appena arrestati alcuni esponenti - durante uno dei loro attacchi. Non uno qualsiasi, e neanche uno dei migliori riusciti: quello dello scorso agosto al Vaticano.

In realtà, a scorgere il documento il nome del Vaticano non compare da nessuna parte (si parla solo di un attacco avvenuto nel 2011 e durato 25 giorni), ma come racconta il New York Times, due persone coinvolte nell’analisi confermerebbero che quella fatta da Imperva riguardi proprio i siti dello Stato Pontificio. E sarebbero stati proprio gli addetti alla sicurezza del Vaticano a commissionare all’agenzia californiana un report sul fallito attacco, rinominato Operation Pharisee (Operazione Farisei).

I fatti risalirebbero all’agosto del 2011, nello stesso periodo in cui il papa Benedetto XVI si trovava in Spagna in occasione della Giornata Mondiale della Gioventù, uno dei momenti di massima visibilità per il Vaticano. Proprio per questo Anonymous pensò di colpire il sito organizzatore della giornata, e rivenditore di oggettistica a tema, nell’ottica mandare a monte l’evento stesso e richiamare l’attenzione sui problemi irrisolti degli abusi sessuali ai minori da parte di alcuni sacerdoti. Questo lo scopo, e adesso Imperva rende note anche le tattiche messe in moto da Anonymous per procedere.

In primo luogo c’è stata una vera e propria campagna mediatica: 18 giorni di messaggi, foto, video, link ad articoli postati dagli hacker sul proprio sito, su YouTube, Twitter Facebook e social network, per reclutare altri hacker, e convincerli ad agire contro i siti del Vaticano. Come spiega il report, questa è una delle fasi più delicate di un piano d’azione di hackeragggio, quella tesa a richiamare l’ attenzione su un problema.

Poi è cominciata la fase successiva: studiare il nemico, ovvero cercare i punti deboli del bersaglio (il sito organizzatore dell’evento), i buchi attraverso cui entrare sarebbe stato più facile insomma. È una fase – breve, appena tre giorni- in qualche modo di preparazione, che serve a capire quali sono i punti da sfruttare per potenziale il vero e proprio attacco. In genere è portata avanti da pochi hacker esperti, come spiega ZDNet. In questo caso però i software automatici impiegati allo scopo non rilevarono nessuna falla lasciata aperta, così che gli hackers sono passati alla loro “ultima risorsa”, come la chiama il report di Imperva, negli ultimi due giorni: un attacco DDoS (Distribuited Denial of Service), con cui sovraccaricare il sito preso di mira fino a farlo crashare.

Una mossa a cui anche i meno esperti possono partecipare dai loro computer e smartphone.

Le conseguenze? Solo nel primo giorno il traffico internet del sito preso di mira era stato 28 volte quello medio, 34 il giorno successivo, tanto che il servizio, stando a quanto dichiararono a suo tempo da Anonymous, cominciava a essere disattivato in alcuni paesi. Ma il report di Imperva invece sostiene che il sito resse bene all’attacco, tenendo alla larga gran parte del traffico eccessivo, perché il Vaticano avrebbe fatto dei grossi investimenti in termini di sicurezza. Quelli che verrebbe da pensare sono mancati, addirittura, al dipartimento di giustizia americano e all’Fbi.

Fonte: wired.it

“Nel giorno della nuova Luna, nel mese di Hiyar, il Sole è stato messo in ombra, ed è sparito durante il giorno, alla presenza di Marte”. Ecco Marte, appunto. Sarebbe stata proprio la visibilità del pianeta (combinata con tutti gli altri dati) scritta sul reperto di argilla ritrovato a Ugarit, nell’attuale Siria a spingere gli scienziati a rifare i calcoli. Fino alla fine degli anni Ottanta infatti si credeva che la più antica testimonianza scritta di un’ eclissi di sole mai rinvenuta risalisse al 3 maggio 1375 a.C. Poi però una nuova datazione del reperto stesso, insieme agli altri indizi, Marte prima di tutto, ha portato i ricercatori a mettere di nuovo tutto in discussione. E così l’eclissi più antica di cui si abbia notizia è quella del 5 marzo 1223 a.C.

Prima di allora in realtà le eclissi avevano già affascinato (e spaventato) gli esseri umani. Si racconta, infatti, che molto prima che fosse trovata una spiegazione scientifica per l’oscurazione degli astri, si credeva che qualche dragone o mostro apparisse all’improvviso nel cielo per mangiarsi la luce del sole. Ed era proprio il fattore sorpresa a spaventare (in piena antitesi al fattore previsione che invece oggi ci tieni con gli occhi incollati al cielo per partecipare allo spettacolo delle eclissi). Così che l’unico modo che gli antichi avevano per opporsi alla comparsa improvvisa di quel dragone che arrivava a mangiarsi il Sole era quello di spaventarlo, facendo più baccano possibile, con grida e tamburi.

Fino a quando, intorno al primo secolo a.C, non fosse stato chiaro che quelle ombre momentanee sul Sole erano solo dei fenomeni astrali spiegabili scientificamente, e che non c’era nessun drago nel cielo, le eclissi avrebbero continuato a spaventare. O quantomeno a creare un’atmosfera tetra, come scriveva Omero nella sua Odissea: “E il Sole è scomparso dal cielo, e una nebbia funesta aleggia su tutto”, riferendosi forse all’eclissi totale di Sole avvenuta nel 1778 a.C.

Per i Greci infatti le eclissi erano un cattivo presagio, il segnale che qualche dio dell’Olimpo si fosse adirato. O comunque un segno divino, magari quello di deporre le armi durante una battaglia, come accadde con l’eclissi di sole totale del 585 a.C, negli scontri tra i Medi e i Lidi.

Sarebbero state numerose e più o meno suggestive le occasioni in cui un’eclisse di Sole avrebbe fatto da cornice a eventi importanti. Mentre in tempi più recenti invece lo sarebbe stata come apripista a fondamentali scoperte scientifiche. Come quella dell’ elio (che non a caso prende il nome proprio dal Sole, helios in greco), nel Diciannovesimo secolo, il primo elemento chimico a essere scoperto fuori dalla Terra. Gli indizi sulla presenza nel sole di questo elemento vennero infatti raccolti proprio durante un’ eclissi solare. Una cinquantina di anni dopo, nel 1919, sarebbe stato ancora il passaggio della Luna sulla nostra stella a venire in aiuto alle teorie di Einstein, visto che fu un’eclissi a dimostrare che anche la luce può essere curvata dalla forza di gravità.

Fonte: wired.it

Una sola goccia di sangue per smascherare anche il più subdolo dei tumori. E’ uno degli ambiziosi obiettivi del progetto di un’équipe interdisciplinare – tutta italiana – composta da esperti della Sissa (Scuola internazionale superiore di studi avanzati), dell’ Università di Trieste, dell’Ospedale Santa Maria della Misericordia e dell’ Università di Udine, del Centro di Riferimento Oncologico di Aviano, del laboratorio nazionale di ricerca Sincrotrone Elettra e dell’Istituto per l’Officina dei Materiali del Cnr (Tasc).

L’idea è quella di mettere le nanotecnologie al servizio della diagnosi precoce dei tumori: strumenti che, oltre a consentire l’individuazione di marcatori da campioni prelevati in modo poco invasivo, permettano al contempo il monitoraggio della concentrazione dei farmaci nei tessuti al fine di valutarne l’eventuale tossicità. A questo imponente progetto sono stati destinati circa nove milioni di euro, investiti dall’Associazione italiana per la ricerca sul cancro ( Airc) e dal ministero dell’Istruzione, dell’Università e della Ricerca attraverso il programma denominato Futuro in ricerca. Scienziati di diverse specializzazioni (fisici, chimici, biologi e clinici) condivideranno le proprie competenze per sviluppare una tecnologia sensibile e a basso costo in grado di leggere l’ impronta digitale dell’ espressione proteica, per rilevare marcatori tumorali e verificare l’impatto dei farmaci sull’organismo.

A coordinare il team è Maurizio Prato dell’Università di Trieste e Giuseppe Toffoli del Cro di Aviano. “Il compito del gruppo di ricerca – racconta uno degli scienziati coinvolti, il fisico Alessandro Laio della Sissa, per sei anni in servizio presso il Politecnico federale di Zurigo e tornato in Italia grazie al progetto “Rientro dei cervelli” - è proprio quello di disegnare al computer la proteina che in modo selettivo e specifico funga da esca per i marcatori tumorali. Trovare una proteina capace di riconoscere uno specifico marcatore è un po’ come cercare un ago in un pagliaio, dato che le alternative possibili sono dell’ordine di 100 miliardi”.

Il computer e le simulazioni che questo dispositivo rende possibili saranno lo strumento con cui gli scienziati contano di individuare quell’ esca, per integrarla in un nanodispositivo capace di rilevare ritorni metastatici o tumori primari e, contemporaneamente, di valutare la quantità di farmaco assorbita dai tessuti per arrivare a dosaggi personalizzati. L’efficacia di una terapia, infatti, dipende da diversi fattori quali l’età, il sesso, il peso del paziente: somministrare farmaci in modo mirato non solo può migliorarne il potere curativo, ma anche ridurne gli effetti collaterali. Inoltre, le scoperte del team potranno anche chiarire anche alcuni meccanismi cellulari alla base di molte patologie.

Del cospicuo finanziamento, Laio gestirà una tranche da 700mila euro: “Saranno determinanti – spiega il fisico - per acquisire nuova strumentazione e reclutare almeno tre giovani ricercatori nel mio gruppo di ricerca”. Proprio il coinvolgimento di giovani studiosi è infatti alla base del programma “ Futuro in Ricerca”, con cui il Miur intende favorire il ricambio generazionale e il sostegno alle eccellenze scientifiche emergenti presenti negli atenei e negli enti di ricerca.

Fonte: wired.it

È un business che – è il caso di dirlo – non muore mai. Secondo una recente ricerca della Camera di Commercio di Monza e Brianza, le imprese funebri, oltre 25mila in Italia, fatturano quasi un miliardo di euro all’anno e gli affari vanno a gonfie vele: più 1,2% rispetto al 2010, con una crescita delle aziende nel settore del 4,7%. Altro che crisi: i funerali non conoscono flessioni di sorta. Per dirla con una celebre frase de I soliti ignoti di Monicelli, “è la vita: oggi a te, domani a lui”. Prima o poi, se ne vanno tutti.

Ma anche morire è diventato un lusso che non tutti si possono permettere: 5.600 euro, stima l’ Associazione per la difesa e l’orientamento dei consumatori (Adoc), è il prezzo medio per l’estremo addio, tra feretro, carro funebre, certificato di decesso, personale d’assistenza, annunci mortuari, corone di fiori, cerimonia in chiesa, con offerta annessa, tassa di tumulazione, lapide e concessione del loculo al cimitero. Un conto salatissimo, che ha registrato un’ impennata del 53,6%, pari a quasi 2mila euro di differenza tra il 2001 e il 2011. Se il servizio è organizzato dal comune, anziché da un’agenzia privata, il prezzo scende del 30 per cento, ma al giorno d’oggi la perdita di una persona cara è comunque una stangata per le finanze familiari. Ecco allora che spuntano un po’ dappertutto offerte e pacchetti per esequie low-cost. Sì, perché anche quello delle imprese funebri è un mercato competitivo che richiede di stare al passo con i tempi. E magari farsi pure un po’ di promozione, con quella giusta dose d’ironia che aiuta a esorcizzare l’ineluttabile.

Funerale a rate

È in voga già da alcuni anni la richiesta di prestiti rateizzati per affrontare l’aldilà. Un italiano su tre sceglie di dilazionare oggi la spesa che, altrimenti, ricadrà sulla famiglia domani, in un colpo solo. E sempre più spesso le imprese funebri stipulano accordi con finanziare per offrire direttamente il servizio agli interessati. Nessuna, però, finora lo aveva sponsorizzato così efficacemente. “ Perché piangere due volte? Funerali completi da 99 euro al mese”. Questo è l’annuncio dei servizi funerari Taffo che campeggia per le strade di Roma e dintorni. “ Al momento della dipartita di una persona cara, ci si può trovare impreparati a sostenere una spesa extra, dovendo sacrificare i propri risparmi o ripiegando su onoranze insoddisfacenti”, dice Alessandro Taffo, 28 anni, uno dei titolari dell’azienda che organizza 90-100 funerali al mese nella capitale: “ Così abbiamo pensato di offrire soluzioni in comode rate da 18 mesi per un pacchetto funebre all-inclusive, economico e assolutamente dignitoso”. A proposito dello slogan scanzonato, aggiunge: “ Volevamo distinguerci dalle altre imprese che organizzano funerali last-minute”. E ci sono riusciti, lanciando fra l’altro una campagna di sensibilizzazione per la sicurezza stradale dai toni non meno geniali. “ Se hai sonno fermati subito! Meglio riposare in auto che da noi”. “ Non correre oltre i limiti. Noi non abbiamo fretta di vederti”. Oppure: “ Fai allacciare le cinture anche agli altri passeggeri. Non costringerci a fare gli straordinari”. E ancora: “ Mantieni sempre la distanza di sicurezza: E noi faremo altrettanto”.

Cremazione certificata

L’acquisto di un loculo per la tumulazione costa quasi come un appartamento: si viaggia sui 3-4 mila euro al metro quadro. L’inumazione in terra è più economica, ma l’opzione meno dispendiosa in assoluto resta la cremazione: per legge il prezzo massimo non può superare i 562,55 euro (nel 2011) e alcuni comuni la offrono gratis ai residenti. Anche considerando il costo della bara, obbligatoria, è conveniente. Difatti, la cremazione è in aumento, tanto da interessare ormai il 10 per cento dei decessi, soprattutto nel Nord e Centro Italia dove si concentra la maggior parte degli impianti autorizzati. A Milano, addirittura, le persone che si fanno cremare dopo la morte (il 60 per cento) hanno sorpassato quelle che finiscono al cimitero. La volontà va espressa in vita, con una dichiarazione o testamento, oppure iscrivendosi ad associazioni riconosciute, come la Federazione italiana per la cremazione o l’Istituto della cremazione e dispersione delle ceneri. Serve poi l’autorizzazione a procedere del comune dove la persona è venuta a mancare. L’urna con i resti del defunto può essere posizionata al camposanto, e dal 2001 la legge 130 consente anche di conservare le ceneri a casa o disperderle nell’ambiente. Le regole variano ed è bene informarsi presso la polizia mortuaria o gli uffici di competenza. In linea generale, il coniuge o un altro familiare stretto viene incaricato di liberare i resti. Si può fare nei cimiteri, in aree private, in natura, persino in mare, purché in un tratto libero da natanti e manufatti. Di fatto, la legge vieta espressamente solo di spargere le ceneri nei centri abitati. Raccomandazione ai fedeli: alla Chiesa la pratica non piace.

Sepoltura a impatto zero

Chi la sceglie come forma di espiazione dei peccati ambientali commessi in vita. Chi lo fa perché ha un’ anima ecologista fino alla morte e anche oltre. Chi perché, più prosaicamente, s’è fatto due conti in tasca. Fatto sta che i funerali verdi, di moda negli Usa e in Gran Bretagna, cominciano a prendere piede anche in Italia. Da quest’anno, l’impresa funebre Pagliarin, a Venezia, offre urne cinerarie in mais e bare in cartone verniciato. Rispettano l’ambiente, evitando di seppellire materiali e metalli inquinanti. E consentono un risparmio del 30 per cento rispetto alle casse di legno verniciato. Siccome l’occhio vuole la sua parte, le bare di cartone sono rivestite con un foglio di cellulosa sul quale si può stampare un’immagine a scelta, un cielo azzurro per esempio, o una tinta del tutto simile al legno. Sono già i 20 i funerali a impatto zero celebrati nella laguna.

Gli ambientalisti duri e puri non si accontentano. Sognano alternative più ecologiche alla cremazione che comporta l’emissione di gas inquinanti nel processo di combustione. Per esempio, la resomazione (che consiste nel liquefare il corpo in una soluzione alcalina) o la criomazione (il cadavere viene raffreddato nell’azoto liquido a -196 gradi °C, essiccato e polverizzato), attualmente praticate all’estero. C’è anche chi propone sepolture naturali, sul modello anglosassone dei Green Burialpark, come il progetto Capsula mundi: è un contenitore a forma di uovo, totalmente biodegradabile dove il corpo verrebbe posizionato in posizione fetale e interrato per trasformarsi in un albero (ma al momento in Italia è vietato). Forse così un giorno il colore del lutto non sarà più il nero, ma il verde.

Fonte: wired.it

Milano e Roma sono fra le dieci città europee maggiormente esposte ai rischi legati agli attacchi informatici. Sono rispettivamente settima e ottava in questa classifica guidata da Manchester, Amsterdam e Stoccolma, frutto di una indagine commissionata alla società di ricerca Sperling’s Best Places da Symantec, che ha diffuso oggi i risultati in occasione della presentazione della nuova versione (la sesta) della propria security suite Norton 360. Davanti a Milano e Roma ci sono Parigi, Londra e Dublino, mentre dietro chiudono la top ten Barcellona e Berlino.

Sperling ha determinato le classifiche per comportamenti degli utenti, incidenza di pc e smartphone, utilizzo di social network, accesso a hotspot Wi-Fi potenzialmente non sicuri e ha poi comparato tutto con i dati degli attacchi informatici registrati nelle diverse città. L’elevata presenza di hotspot, insieme agli attacchi con malware, ha portato Manchester in cima alla classifica.

Andando a spulciare le singole graduatorie si nota che Roma è la capitale europea dei bot, con una media di 1.314 computer controllati in remoto da hacker per inviare spam e altri attacchi informatici, contro i 147 di Manchester e i 307 di Milano. Milano che a sua volta è la prima nella classifica dei tentativi di attacchi via Web (555 in media, circa il doppio della seconda, Amsterdam, e di Roma, quarta) e per indirizzi ip di spammer (3.768) seguita in questo caso proprio da Roma (1.246). Le due città italiane sono inoltre seconda e quarta nella classifica dei tentativi di attacco con malware.

Per quale motivo allora non sono in testa alla classifica delle città più pericolose? Milano ha ottenuto il massimo punteggio aggregato per i dati sulla criminalità informatica, ma ha un basso livello di penetrazione di pc (a Manchester i computer per famiglia sono il doppio), di utilizzo di Internet (49,2%, il più basso insieme a Roma, dopo Barcellona ferma al 62,2%) e di presenza di hotspot Wi-Fi (34,9 ogni 100 mila persone, peggio solo di Roma ferma a 21,9, ben distante dai 445,4 di Manchester). Allo stesso modo, milanesi e romani sono relativamente meno esposti agli attacchi anche per via della minore presenza nei social network (45,8% della popolazione, mentre le altre città sono sopra il 61%). Non che questi siano di per sé pericolosi, ma come pc e smartphone rappresentano una porta d’ingresso per le minacce.

Come ci si difende? Le regole sono sempre le solite, spiega Symantec: cautela nell’uso di hotspot wi-fi, più esposti allo cattura di password e informazioni tramite sniffing, anti-virus e security suite costantemente aggiornate e password complesse e uniche per ogni sito.

Fonte: wired.it

Non ci sono solo la Tav e i no Tav. A guardare la mappa del Nimby Forum – un osservatorio promosso dall’associazione no profit Aris (Agenzia di Ricerche Informazione e Società) che si occupa di monitorare le opposizioni territoriali in materia di ambiente contro opere di pubblica utilità - non ci sono Regioni immuni da contestazioni. Dalla Val d’Aosta alla Sicilia sono 331 in totale i progetti in fase di stallo, a cui i cittadini, comuni e comitati dicono no. Not In My Back Yard ( Nimby) per la precisione, ovvero non nel mio giardino, o comunque non sul mio territorio. Un dato che sembrerebbe quindi ben motivare le recenti intenzioni del governo di modificare la legislazione in materia di grandi opere a favore di un modello di democrazia partecipativa alla francese, che coinvolga i diretti interessati nella realizzazione di un progetto.

Rispetto al 2010, nel rapporto del Nimby Forum si parla di un aumento del 3,4% delle contestazioni, 163 delle quali sorte solo nel 2011 (il calcolo totale considera quelle effettivamente registrate nel corso dell’anno analizzato), come rivela lo studio di carta stampata nazionale, locale e del Web (dal momento che non esiste un archivio con la lista di tutti i progetti in corso o ancora da approvare). E in molti casi (poco più della metà, il 51%) non si parla neanche di progetti in cantiere, letteralmente, ma solo di idee, ancora da sviluppare formalmente.

Il nord e il centro sono le aree in cui si concentra il maggior numero di opposizioni, mentre nella classifica delle Regioni con più contestazioni spicca la Lombardia, con 46 progetti in bilico. Segue la Toscana (42) e completa il podio il Veneto (40). E i progetti messi in discussioni sono dei più vari: da impianti eolici e fotovoltaici alle centrali a biomassa, e poi centrali idroelettriche, discariche, termovalizzatori, gassificatori e rigassificatori. Ovunque cioè ci sia una problematica di tipo ambientale.

Ecco allora che accanto alle opere del comparto elettrico contestate (pari a circa il 62,5%), a quello dei rifiuti (che contribuisce per un 31,4%) ci sono anche quelle per le infrastrutture (4,8%) seguite in coda dalle proteste contro la realizzazione di impianti industriali (1,2%). Se a questo si aggiunge il fatto che dei 331 progetti contestati 156 sfruttano le rinnovabili, appare chiaro come gran parte delle discussioni riguardino proprio quelle tecnologie verdi che almeno a prima vista sembrerebbero invece essere accolte positivamente.

Il rapporto reso noto dal Nimby Forum non si limita a disegnare una mappa del fenomeno, e delinea anche quali sono i soggetti che portano avanti le contestazioni e le loro motivazioni. Ecco allora che quelle di matrice popolare appaiono le più forti, con il 36%. Seguono i soggetti politici e gli enti pubblici nella lista dei più dissidenti. Ma se si seziona bene il gruppo dei contestatori emergono dati interessanti, che parlano di soggetti politici locali, comuni e comitati come i principali attori delle opposizioni. Anche se sono sempre le amministrazioni locali le parti più favorevoli alla realizzazione dei progetti contestati, visti principalmente come un’opportunità per lo sviluppo del territorio.

Non stupiscono, proprio come accade nel caso delle contestazioni in Val di Susa, i motivi che spingono a scendere in piazza e dire no agli impianti in costruzione (o anche solo ai loro progetti). Impatto ambientale (soprattutto nel campo delle infrastrutture) e qualità della vita guidano la classifica delle problematiche alla base delle contestazioni, ma anche questioni burocratiche, come le difficoltà incontrate nelle procedure di autorizzazione. Le stesse che sembrerebbero, come racconta il Sole24ore, aver spinto la British Gas ad aver abbandonato il progetto di un rigassificatore a Brindisi, dopo aver atteso invano per 11 anni i permessi necessari ad avviare l’opera. Tempi normali? Non proprio, considerando che in Galles un impianto praticamente identico nello stesso lasso di tempo è stato progettato, approvato, costruito e diventato operativo.

Fonte: wired.it

Coca Cola e Pepsi modificano le ricette. Appena appena, solo per quello che riguarda un colorante. È l'unico modo per evitare di dover scrivere sull'etichetta “ nuoce gravemente alla salute”, o qualcosa del genere.

Il motivo porta il nome della molecola 4- metilimidazolo, quella che si forma durante la preparazione di un tipo di caramello usato nelle bibite e in altri alimenti (per la precisione il caramello solfito-ammoniacale, indicato nelle etichette con la sigla E150D). Lo Stato della California lo appena ha inserito nella lista nera delle sostanze cancerogene. Qui la produzione delle bevande si è già adeguata e presto la nuova ricetta sarà diffusa su tutto il mercato statunitense, per una questione di efficienza di produzione. Attualmente le lattine vendute negli Stati Uniti contengono circa 140 microgrammi della sostanza sotto accusa, mentre il limite, in California, è fissato a 29, come riporta Reuters.com.

"Siamo certi che non vi sia alcun rischio per la salute pubblica che possa giustificare dei cambiamenti [nella ricetta], ma abbiamo ugualmente chiesto ai nostri fornitori di caramello di tenerne conto, affinché i nostri prodotti non siano bersagliati da messaggi allarmanti scientificamente infondati”, ha detto Diana Garza-Ciarlante, una rappresentante della Coca-Cola Co., ad Associated Press, in una dichiarazione ripresa anche dalla Bbc. In ogni caso, i consumatori – assicurano entrambe le aziende – non si accorgeranno di nulla.

Il 4-metilimidazolo è stato correlato da alcuni studi allo sviluppo di tumori in topi e ratti e un'analisi pubblicata circa un anno fa su Lancet Oncology dallo Iarc, l'Agenzia internazionale per la ricerca sul cancro dell'Organizzazione mondiale della sanità, lo indicava tra le sostanze “ possibilmente cancerogene” ( gruppo 2B).

Secondo l' American Beverage Association, invece, non ci sarebbe alcun rischio per i consumatori: la California avrebbe bandito la sostanza senza alcuno studio che ne comprovi l' effetto cancerogeno negli esseri umani.

Per i produttori PepsiCo Inc. e Coca-Cola Co. il tormento è cominciato lo scorso febbraio, quando il Centre for Science in the Public Interest (Cspi), un'associazione di consumatori, ha sottoposto una petizione (la seconda in realtà) alla Food and Drug Administration affinché quel colorante fosse vietato. Al momento, la petizione è al vaglio dell'agenzia regolatoria. La quale, però, ha già sottolineato che una persona dovrebbe bere oltre mille lattine al giorno per raggiungere la dose risultata cancerogena per gli animali considerati negli studi in questione. Attualmente esiste un limite per questo colorante stabilito dalla stessa agenzia ed è di 250 parti per milione. I livelli riscontrati anche nella analisi della Cspi sono di 0,4 ppm.

Fonte: wired.it

L’ 11 marzo 2011, poco dopo il terrificante terremoto di magnitudo 9, uno tsunami si abbatte sulla costa orientale giapponese, investendo la centrale nucleare di Fukushima Daiichi. Onde alte più di 10 metri sorpassano le barriere protettive, di appena cinque metri e mezzo, e inondano i sei reattori. È black-out. I sistemi di raffreddamento saltano. Inizia così una corsa contro il tempo per evitare la catastrofe, solo in parte sventata grazie al disperato ricorso all’ acqua di mare, gettata sui reattori con idranti ed elicotteri. Non basterà a evitare fusioni parziali del nocciolo nei reattori 1, 2 e 3, incendi ed esplosioni nei reattori 2, 3 e 4. Dallo scorso dicembre, nove mesi dopo l’incidente, la situazione è stabile, con i reattori in stato di chiusura fredda, una condizione che non implica rischi immediati. Di sicuro, è stato il peggiore incubo atomico che il Giappone ricordi e l’unico altro incidente, insieme a Chernobyl, classificato come livello 7, il massimo della scala Ines. Ma fu davvero così catastrofico? Un anno dopo, è ancora difficile rispondere.

Chernobyl victim.

Anche se la centrale Fukushima non sta più rilasciando isotopi radioattivi nell’aria, come iodio-131 e cesio-137, non è chiara quale sia stata la reale portata della contaminazione. A maggio è atteso un rapporto del Committee on the Effects of Atomic Radiation delle Nazioni Unite che dovrebbe fare un po’ di chiarezza. Intanto, al primo anniversario dell’incidente, sono emersi nuovi particolari inquietanti. Secondo un rapporto della Rebuild Japan Initiative Foundation, un’organizzazione indipendente costituitasi per indagare su Fukushima, nei drammatici giorni dopo l’11 marzo il governo considerò l’ipotesi di evacuare Tokyo, che si trova a circa 250 chilometri da Fukushima. Non s’arrivò a tanto, ma più di 100mila persone, residenti nel raggio fino a 40 chilometri dalla centrale, sono ancora sfollate e almeno 25mila non potranno far ritorno nelle loro case per i prossimi cinque anni a causa delle radiazioni.

Il quadro, tuttavia, potrebbe essere meno drammatico. Sembra che l’esposizione della popolazione alle radiazioni sia stata minima, anche grazie ai venti che giocarono a favore, spirando verso il mare. Secondo le ricerche effettuate dalla Fukushima Medical University, il 99,3 per cento delle 10mila persone residenti vicino alla centrale e sottoposte a screening avrebbero ricevuto meno di 10 millisieverts (mSv) di radioattività nei primi quattro mesi dopo l’incidente. La dose più alta registrata è stata 23 mSv, ben inferiore alla soglia di 100 mSv collegata a un più elevato rischio di cancro. Questi dati sono in linea con le analisi presentate da un panel di ricercatori statunitensi, secondo cui le conseguenze a Fukushima non saranno minimamente paragonabili a quelle del disastro di Chernobyl. Persino i lavoratori dentro la centrale – hanno riferito gli scienziati alla conferenza della Health Physics Society – sono stati esposti a livelli di radiazioni 10 volte inferiori rispetto alle 500mila persone che costruirono il sarcofago sopra la centrale ucraina, esplosa nel 1986. A Fukushima, il rischio di ammalarsi di tumore potrebbe aumentare dello 0,002%, e la probabilità di morire dello 0,0001%. Troppo poco perché si possa distinguere i casi di tumore connessi all’incidente nucleare rispetto all’incidenza nella popolazione generale.

Si tratta comunque di conclusioni provvisorie che lasciano scettici alcuni esperti. Come Hisako Sakiyama, attivista anti-nuclearista e ex biologo al National Institute of Radiology, il quale sostiene che, mentre i danni provocati dalle esposizioni acute alle radiazioni sono ben noti, gli effetti sulla salute di basse esposizioni, ma prolungate nel tempo, sono in gran parte sconosciuti.

Al di là dell’esposizione diretta, poi, restano le preoccupazioni sulla contaminazione degli alimenti. Secondo l’ultimo rapporto dell' Agenzia internazionale per l'energia atomica (Aiea) l’1% delle circa 14mila analisi svolte su cibi giapponesi fornisce ancora valori superiori ai limiti di sicurezza per il cesio 137, e una particolare specie di funghi della prefettura di Tochigi continua ad avere restrizioni sulla vendita. Tra marzo e novembre scorsi, hanno subito restrizioni alla vendita e divieti pesce, alghe, spinaci, funghi, carne, tè e latte.

Altre analisi stanno valutando le conseguenze della radioattività sull’ ecosistema naturale. Non così drammatiche, per fortuna. Però gli uccelli nella regione di Fukushima si sarebbero ridotti di un terzo, secondo Tim Mousseau, ecologo della University of South Carolina in Columbia, e nell’oceano, sostiene Ken Buesseler, chimico marino della Woods Hole Oceanographic Institution, plutonio e stronzio radioattivo potrebbero accumularsi nei pesci vicino al reattore.

In termini economici, il danno complessivo alla regione di Fukushima è stimato in miliardi di dollari.

Fonte: wired.it

Scegliere le parole giuste non è facile, forse proprio per colpa del computer. Niente a che fare con la mancanza di contatto con la penna e il foglio, piuttosto si tratterebbe di un dettaglio di fabbricazione delle tastiere Qwerty. Infatti, comporre parole con caratteri situati a destra dei tasti t, g, b sarebbe più facile. Come se non bastasse, a queste parole verrebbe attribuita anche una connotazione positiva. Il perché ce lo spiega Kyle Jasmin, neuroscienziato all' University of College London, in uno studio pubblicato su Psychonomic Bulletin and Review.

Tutto dipende dal fatto che le lettere sono disposte in modo asimmetrico sulla tastiera Qwerty, brevettata nel 1868 dall'americano Christopher Sholes. La fila di centro – delimitata dai tasti t, g, b – divide il piano di scrittura in due parti diseguali: la parte sinistra contiene infatti più lettere rispetto a quella destra. Quanto basta per causare una nostra innata predilezione per le parole composte di caratteri destrorsi, visto che il cervello deve fare meno fatica per individuare i tasti corretti.

Un dettaglio tutt'altro che trascurabile, visto che oggi trascorriamo buona parte della giornata digitando messaggi su tastiere di computer, smartphone e tablet. Possibile mai che questo disequilibrio a destra possa condizionare le nostre scelte stilistiche? Jasmin ha condotto tre diversi studi per verificare se il posizionamento dei caratteri qwerty possa avere un impatto sulla semantica moderna.

Il primo esperimento consisteva nell'analizzare le emozioni personali di 132 madrelingua olandesi correlate alle parole composte in maggioranza da tasti posizionati a destra (e viceversa). Tutto ciò ripetuto per tre lingue differenti (olandese, inglese e spagnolo) e con più di mille parole. Ebbene, a prescindere dalla lingua, sembra che il cervello tenda a associare alle lettere destrorse significati positivi.

Il secondo e terzo esperimento erano invece pensati per valutare se il significato delle parole senza senso e di quelle nate dopo l'introduzione della Qwerty fosse stato influenzato maggiormente dal disequilibrio della tastiera. In questo caso, il campione era composto da 800 madrelingua inglesi, visto che la maggior parte dei neologismi della rete è nata nei paesi anglosassoni. Anche in questo caso, la parte destra ha registrato connotazioni più positive.

Secondo Jasmin, l'uso massiccio della tastiera ci starebbe guidando verso un vocabolario strettamente legato alla geografia Qwerty. Neppure le persone mancine sarebbero immuni al fascino del lato destro, sebbene alcuni studi ritengano che in genere la mano dominante abbia un influsso positivo sulla digitazione.

Insomma, il nostro vocabolario del futuro sembra legato alla Qwerty ma, tutto sommato, questo disequilibrio è dovuto al caso. Il nome della tastiera deriva dal fatto che i 6 caratteri della prima fila siano stati appositamente collocati in quella posizione dai costruttori per comporre velocemente la parola typewriter, “ macchina da scrivere”. Esiste però una tastiera di fabbricazione più recente, la dibattuta variante Dvorak, in cui le lettere sono disposte in modo differente. A voi la scelta.

Fonte: wired.it

|

|

Ci sono 7324 persone collegate

|

<

|

aprile 2024

|

>

|

L |

M |

M |

G |

V |

S |

D |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

10 |

11 |

12 |

13 |

14 |

15 |

16 |

17 |

18 |

19 |

20 |

21 |

22 |

23 |

24 |

25 |

26 |

27 |

28 |

29 |

30 |

|

|

|

|

|

| |

|

|

|

|

|

|

19/04/2024 @ 09:45:36

script eseguito in 697 ms

|